Данная схема описывает ряд взаимодействий, которые пр

metanymous в посте Metapractice (оригинал в ЖЖ)

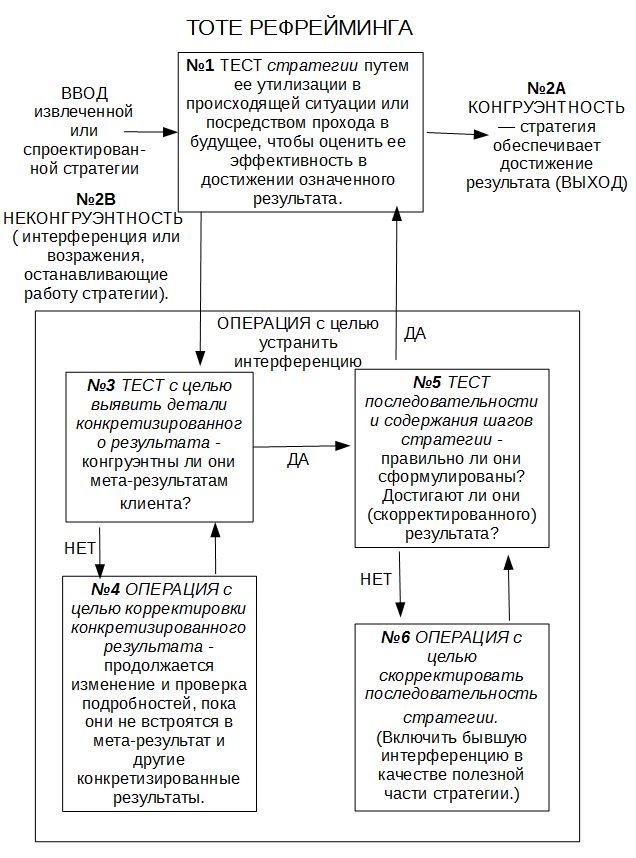

Данная схема описывает ряд взаимодействий, которые проходят в следующем порядке:

1. Существующая или «с нуля» спроектированная стратегия проходит тест, цель которого — выяснить, достигает ли она соответствующего результата. Это можно сделать путем создания (или воссоздания) специфических контекстуальных условий запуска стратегии во внутренних репрезентациях — чтобы индивид припомнил специфические переживания, или же посредством прохода в будущее. Также этого можно достичь посредством предъявления соответствующих условий в текущем внешнем контексте. Индивида следует провести через каждый шаг стратегии так, чтобы можно было оценить выполнимость и эффективность стратегии в целом.2А. Если последовательность стратегии действительно соответствует контексту и может быть выполнена, результат будет достигнут беспрепятственно, и стратегия завершится выходом в некоторую другую программу поведения.2B. Если результат работы стратегии не является удовлетворительным, или если он нарушает личную экологию индивида, в некоторой точке выполнения стратегии возникнет неконгруэнтность или интерференция — либо индивид выполнит шаги стратегии без достижения результата, либо стратегия будет прервана на полпути. Для программиста здесь важно определить, как репрезентируется интерференция (т. е. внутренний ли это голос, ощущение или образ). Самый прямой путь извлечь эту информацию — просто спросить: «Что вас остановило?». Когда вы задаете вопрос, подобный этому, удостоверьтесь в том, что вы уделяете пристальное внимание любым последующим невербальным реакциям, особенно ключам доступа. Зачастую индивид не осознает переживаемую репрезентацию, которая и создает интерференцию, но укажет на нее, отреагировав соответствующим ключом доступа. Программист также должен уделять внимание тону голоса, которым обращается к себе индивид во время выполнения шагов с внутренним диалогом. Например, зачастую индивид говорит себе соответствующие стратегии слова (дискретная часть шага), но произносит их неконгруэнтным тоном.

3. Этот шаг запускает «рефрейминг» (изменение «рамки», фрейма) интерференции. Неконгруэнтность или возражение признается и принимается как ценный ресурс, предоставляющий обратную связь, необходимую для улучшения функционирования стратегии. Программист и индивид начинают работать с интерференцией, определяя ее цель или намерение. Сначала программист стремится провести тест репрезентации результата клиента: не запускаются ли негативные фотопли текущей репрезентацией результата? Иногда индивид боится, что потеряет возможность выбора результата, которого достигал ранее. В качестве примера можно привести индивида, который желает иметь возможность быть более настойчивым в социальных ситуациях, но он на себе испытал, каково это, когда от него «отмахивались» настойчивые люди, и он боится, что сам потеряет способность быть «приветливым». Индивиду может нравиться как это выглядит, но он не чувствует себя при этом правильно. Такого рода возражения можно легко обнаружить путем извлечения последствий достижения результата.Первоначально запись опубликована в блоге НЛП-Практика.Вы можете оставить комментарий здесь или там.

Рефрейминг, рассмотренный с учетом всех его аспектов, становится очень сложным процессом, и мы решили посвятить этой технике отдельную книгу, Рефрейминг. Для целей настоящей книги нами было принято решение представить основные шаги рефрейминга в виде следующего двухчастного ТОТЕ (см. схему):Материал для картирования: связующий п. + второпорядко

metanymous в посте Metapractice (оригинал в ЖЖ)

(2) Постановка вопроса картирования мозга на задаче картирования мозга билингвов выглядит в общем совершенно правильной. Только так и можно картировать мозг – через исполняемые процессы/определённые внешние активности.

Но, ключевая проблема картировании мозга билингвов (как любого другого картирования) есть:

(а) нахождение связующего паттерна для данной активности (попеременной экспрессии двух языков)

(б) выделение из связующего паттерна заданной активности инвариантов второго порядка – именно эти второпорядковые инварианты активности следует отслеживать на различных уровнях нервной системы

Дочитали до конца.