Показаны записи 4811 - 4820 из 30984

Ресурсы нагвализма (N+2) Рекапитуляция

http://metapractice.livejournal.com/502846.html

Рекапитуляция vs EMDR

http://metapractice.livejournal.com/500618.html?thread=12797066#t12797066

http://metapractice.livejournal.com/502846.html

Рекапитуляция vs EMDR

http://metapractice.livejournal.com/500618.html?thread=12797066#t12797066

(1) Трансдеривационный/поисковый запрос к памяти/подсознанию может выглядеть примерно так: следует из всей предшествующей жизни вспомнить примеры, в которых вокруг/рядом с субъектом кто-то болел орз/гриппом, но сам субъект не болел. Вытащить ВСЕ такие примеры технически непросто. Надо описать конкретную технику.

(а) Вспомнить хотя бы один пример(1), из опыта(1)/контекста, когда вы были окружены/с вами был рядом по-крайней мере один сморкающийся, чихающий, кашляющий, температурящий субъект. Они/он болел ОРЗ/гриппом, а вы не болели. Поставить на этом воспоминании якорь(1).

(б) Откалибровать надёжную систему маркирования одним невербальным сигналом(1) опыта(1):

--Для этого добавить к примеру(1), еще хотя бы два примера(2,3) на тему опыта(1).

--Примеры(2,3) закрепить на уже существующий якорь(1).

--задействовать с открытыми/закрытыми глазами EMDR-движения, с "подметающим эффектом" справа-налево.

--по ходу выполнения этих EMDR-движений найти и откалибровать невербальный сигнал(1), означающий доступ к переживаниям класса опыта(1).

(в) Выполнить рекапитуляцию от настоящего к прошлому в поиске ВСЕХ примеров(N) класса опыта(1) - "...когда вы были окружены/с вами был рядом по-крайней мере один сморкающийся, чихающий, кашляющий, температурящий субъект. Они/он болел ОРЗ/гриппом, а вы не болели":

--снова и снова выполнять указанные выше EMDR-движения справа-налево, активизировав исходный якорь(1)

--считать сумму накапливающихся невербальных сигналов(1)

--следить тем или иным путём/методом за ассоциативным продвижением рекапитуляции от всё дальше и дальше в прошлое

--формально зафиксировать получившуюся сумму числа примеров(N)

Итог выполнения техники по извлечению ресурса иммунитета: якорь(1) + формальное число найденных примеров(N)

(а) Вспомнить хотя бы один пример(1), из опыта(1)/контекста, когда вы были окружены/с вами был рядом по-крайней мере один сморкающийся, чихающий, кашляющий, температурящий субъект. Они/он болел ОРЗ/гриппом, а вы не болели. Поставить на этом воспоминании якорь(1).

(б) Откалибровать надёжную систему маркирования одним невербальным сигналом(1) опыта(1):

--Для этого добавить к примеру(1), еще хотя бы два примера(2,3) на тему опыта(1).

--Примеры(2,3) закрепить на уже существующий якорь(1).

--задействовать с открытыми/закрытыми глазами EMDR-движения, с "подметающим эффектом" справа-налево.

--по ходу выполнения этих EMDR-движений найти и откалибровать невербальный сигнал(1), означающий доступ к переживаниям класса опыта(1).

(в) Выполнить рекапитуляцию от настоящего к прошлому в поиске ВСЕХ примеров(N) класса опыта(1) - "...когда вы были окружены/с вами был рядом по-крайней мере один сморкающийся, чихающий, кашляющий, температурящий субъект. Они/он болел ОРЗ/гриппом, а вы не болели":

--снова и снова выполнять указанные выше EMDR-движения справа-налево, активизировав исходный якорь(1)

--считать сумму накапливающихся невербальных сигналов(1)

--следить тем или иным путём/методом за ассоциативным продвижением рекапитуляции от всё дальше и дальше в прошлое

--формально зафиксировать получившуюся сумму числа примеров(N)

Итог выполнения техники по извлечению ресурса иммунитета: якорь(1) + формальное число найденных примеров(N)

Ну да.

Но, прежде чем утилизировать субмодальности, надо откуда-то взять ресурсы на уровне модальностей восприятия!

(1) Трансдеривационный/поисковый запрос к памяти/подсознанию может выглядеть примерно так: следует из всей предшествующей жизни вспомнить примеры, в которых вокруг/рядом с субъектом кто-то болел орз/гриппом, но сам субъект не болел. Вытащить ВСЕ такие примеры технически непросто. Надо описать конкретную технику.

(2) Собранный на якорь опыт из пп(1) следует сублимировать в субмодальности "иммунитета". Техника.

(3) Сублимированные субмодальности "иммунитета" следует интегрировать с текущим моментом и будущим. Техника.

Но, прежде чем утилизировать субмодальности, надо откуда-то взять ресурсы на уровне модальностей восприятия!

(1) Трансдеривационный/поисковый запрос к памяти/подсознанию может выглядеть примерно так: следует из всей предшествующей жизни вспомнить примеры, в которых вокруг/рядом с субъектом кто-то болел орз/гриппом, но сам субъект не болел. Вытащить ВСЕ такие примеры технически непросто. Надо описать конкретную технику.

(2) Собранный на якорь опыт из пп(1) следует сублимировать в субмодальности "иммунитета". Техника.

(3) Сублимированные субмодальности "иммунитета" следует интегрировать с текущим моментом и будущим. Техника.

Ким Нобл - женщина, в которой живёт 20 разных людей

http://dr-rusi4.livejournal.com/6717094.html

http://dr-rusi4.livejournal.com/6717094.html

Когда ученого просили подробно описать этот процесс, он отвечал, что сначала успокаивает все свои чувства, дабы ощутить энергетическую связь с растением. Как только достигнуто равновесие между биоэлектрическими потенциалами растения и человека, растение перестает реагировать на шумы, температуру, окружающие электрические поля и другие растения. Оно реагирует только на Вогеля, который смог хорошо настроиться или просто загипнотизировать растение.

Растение вместе с подключенным к нему индикатором становится чем-то вроде интерфейса DHE. А гипнотизировал он самого себя.

Растение вместе с подключенным к нему индикатором становится чем-то вроде интерфейса DHE. А гипнотизировал он самого себя.

</>

Растения "читают" только сфокусированные/сосредоточен

metanymous в посте Metapractice (оригинал в ЖЖ)

Вогель разделил своих студентов на три группы и дал им задание повторить опыты Бакстера, но ни одна группа не добилась положительного результата. Сам же Вогель оказался более удачливым, и он смог повторить некоторые результаты экспериментов Бакстера. Он продемонстрировал слушателям, как растения предчувствуют, что им оторвут листья и тревожатся при одной только угрозе сожжения или выдергивания с корнем. Эта угроза вызывает у них даже больше беспокойства, чем реальное вырывание, сожжение или повреждение. Но странно: почему же никто, кроме него, не смог повторить этот эксперимент? В детстве Вогель интересовался всем, что связано с работой человеческого сознания. Он проштудировал немало литературы о магии, спиритизме и гипнозе, и еще подростком давал публичные сеансы гипноза.

В результате своего опыта Вогель умел сосредоточивать свои мысли, а его студенты не умели.

Растения "читают" только сфокусированные/сосредоточенные мысли.

В результате своего опыта Вогель умел сосредоточивать свои мысли, а его студенты не умели.

Растения "читают" только сфокусированные/сосредоточенные мысли.

Ну, это время сравнимо со временем, за которое по инструкции аппарата наступает эффект электро сна.

В моём случае, первый эффект я осознавал уже через минуты. Через 15 минут эффект был хорошо заметен.

Через полчаса эффект был сильно выражен.

И т.д.

В моём случае, первый эффект я осознавал уже через минуты. Через 15 минут эффект был хорошо заметен.

Через полчаса эффект был сильно выражен.

И т.д.

</>

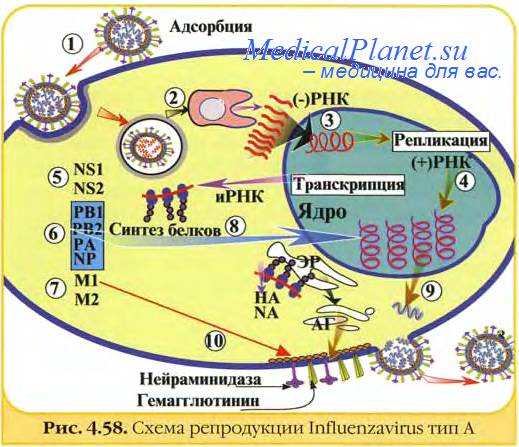

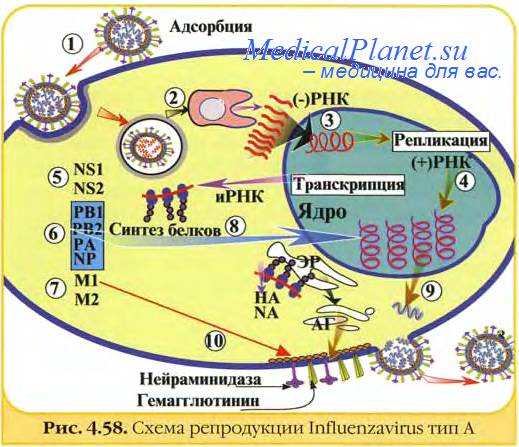

![[pic]](http://medicalplanet.su/Img/262.jpg)

Источники ресурсов (13) Психологические ресурсы против свиного гриппа

metanymous в Metapractice (оригинал в ЖЖ)

http://metapractice.livejournal.com/498095.html

У нас есть "стратегия автоматического выздоровления" (САВ) от уже протекающих болезней. Но, с эпидемией свиного гриппа было бы здорово вообще не подцепить этот грипп, - не заболеть, не смотря на набирающую обороты эпидемию. Для решения такой задачи нам потребуется найти и мультиплицировать для САВ особенный ресур.

Уточнение стратегии автоматического выздоровления

http://www.slideshare.net/AnatolyTkachev/emdr-54694428

http://metapractice.livejournal.com/495192.html

У нас есть "стратегия автоматического выздоровления" (САВ) от уже протекающих болезней. Но, с эпидемией свиного гриппа было бы здорово вообще не подцепить этот грипп, - не заболеть, не смотря на набирающую обороты эпидемию. Для решения такой задачи нам потребуется найти и мультиплицировать для САВ особенный ресур.

Уточнение стратегии автоматического выздоровления

http://www.slideshare.net/AnatolyTkachev/emdr-54694428

http://metapractice.livejournal.com/495192.html

Ага! Сигналинг!

Ну, тогда, давай сюда догадки/калибровки прикидок по такому сигналингу!

Ну, тогда, давай сюда догадки/калибровки прикидок по такому сигналингу!

</>

Re: Бандлер любит подобные модели внутреннего мира

metanymous в посте Metapractice (оригинал в ЖЖ)

Ну, Бандлер внушает эти ячейки для терапии.

А какую терапию делает Матурана в своих теориях? промывает мозги?

А какую терапию делает Матурана в своих теориях? промывает мозги?

Дочитали до конца.